看了兩場關於 Agentic Search 的演講,分別來自 AWS OpenSearch 的 John Handler 和 AI-Powered Search 這本書的作者 Doug Turnbull (這有很多檢索知識文章,超讚),兩位都在探討: AI Agent 是否正在取代幾十年累積的搜尋智慧?

閱讀全文〈Agentic Search: 搜尋技術不會消失,只是變成 Agent 工具〉愛好 AI Engineer 電子報 🚀 2025 Q4 AI 模型與 Agent 開發 #33

Hello! 各位 AI 開發者大家好 👋

2025 Q4 各家陸續推出新模型,SOTA 模型輪流當。以下整理新模型消息,以及集結我最近發表的內容。

閱讀全文〈愛好 AI Engineer 電子報 🚀 2025 Q4 AI 模型與 Agent 開發 #33〉AI Agent 產品開發仍然不簡單

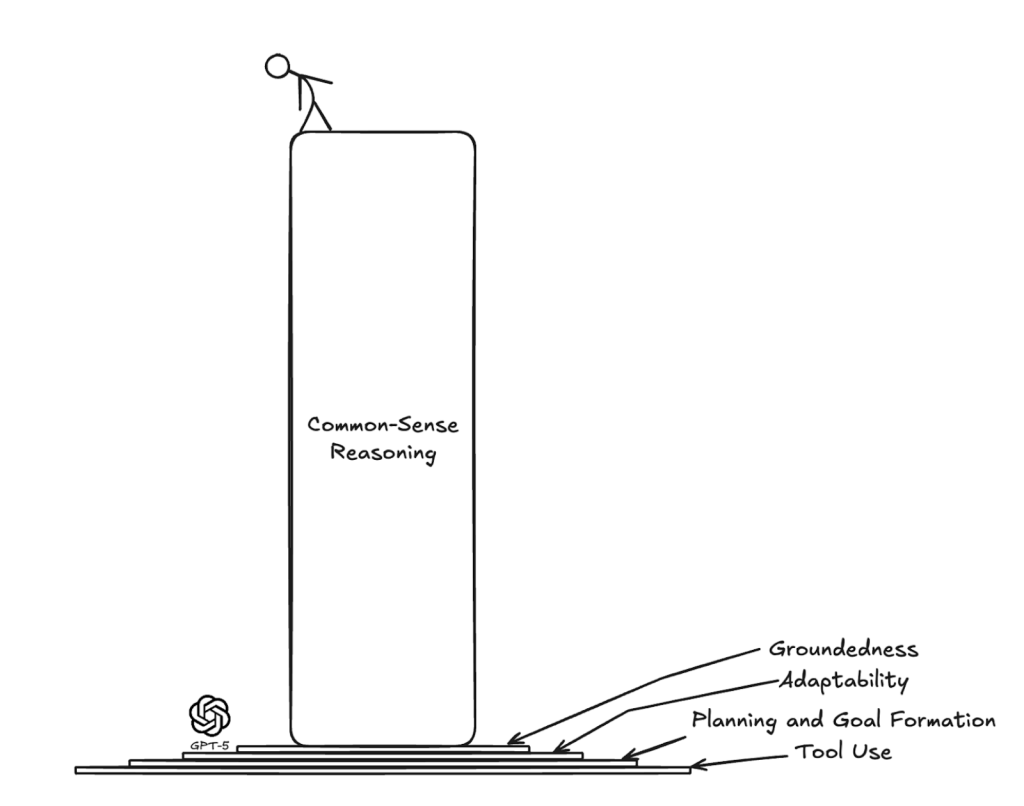

在講完 WebConf 之後,我有種莫名的不協調感: 一方面 Vibe Coding 讓大家寫程式變簡單了,人人都可以做 App 了,也很多人講硬技能不重要了。但另一方面,我覺得開發 AI Agent 產品仍是非常有技術挑戰性的,需要的知識技能深度廣度一點都不少。

最近也看到了幾篇關於 AI Agent 開發的文章,發現國外技術社群在 2025 Q4 也有類似的體悟: Agent 產品開發設計還是很難。

不是「寫程式很難」那種難,而是「95% 的 AI Agent 產品,進到正式環境會失敗」這種難。問題不在模型不夠聰明,而在於周邊的工程架構: context 管理、memoy 設計、錯誤處理、agent prompt 最佳化、語意檢索、評估回饋機制等等,很多都是全新領域,且戰且走的情況。模型只能用幾個月就要升級更換,幾個月前的 best practice 也可能會被推翻重新思考。

總之,以下我整理年底四篇我覺得關於 Agent 開發氛圍的不錯文章:

閱讀全文〈AI Agent 產品開發仍然不簡單〉實戰 AI Agents 應用開發: TTFT 和 Prompt Caching

2025/12/13 在 WebConf Taiwan 分享的演講投影片 ➡️ 這裡下載PDF(32mb)

如果你還沒有訂閱我的電子報,歡迎訂閱 📬 愛好 AI Engineer 電子報。

議程介紹:

AI Agent 正逐漸成為 Web 應用產品中的關鍵功能,從工作流程到 AI 智慧助理,開發者開始讓 Agent 融入 Web 應用的系統架構。

延續去年「淺談 AI Agents 應用開發」的基礎,今年我們從實戰角度出發,介紹如何在 Web 環境下開發、部署與最佳化 AI Agent 系統。本次分享將以 Python FastAPI + OpenAI Agents SDK + 前後端分離架構為例,展示如何讓 Agent 流暢地進行串流輸出,以 TTFT (Time To First Token) 與 Prompt Caching 優先的系統架構。同時也探討前端的 Agent UI 設計、可觀測性、Agent 評估、上下文工程(Context Engineering) 等實務技巧。多方面探討如何在 Web 環境上打造 AI Agent 系統。

Spec-Driven Development(SDD) 的美好願景與殘酷現實

(整理分享一些關於 Spec-Driven Development (SDD) 的看法和內容)

Spec-Driven Development (SDD) 是什麼? 簡單說講就是在用 AI 寫程式之前,先讓 LLM 生成一大堆規格文件: 產品需求 → 技術設計 → 任務清單,然後才交給 coding agent 執行。目前有幾個工具在推這套流程: GitHub 的 Spec-Kit、AWS 的 Kiro、還有 Tessl。

社群討論其實非常兩極。正面看法認為遠比 vibe coding 可靠、適合要上線維護的真實專案、開發速度中期來看其實更快。負面看法則認為這就是 Waterfall 2.0、過度工程化、扼殺創造力。我自己從一開始就不太看好,最近看到幾篇深度分析文章,更加印證了我的看法。

閱讀全文〈Spec-Driven Development(SDD) 的美好願景與殘酷現實〉